You are here

马哥 45_01 _http反向代理及haproxy 有大用

nginx是一个反向代理,

是Reverse Proxy : http,pop3/imap4

同时是web server

Nginx:

反向代理 单个URI (可以正则),代理至后端某服务器

可以使用if 重定向

proxy_pass, rewrite 区别

upstream:将一组后端服务器定义为一组负载均衡集群

rr: 加权轮调

ip_hash: 原地址hash,,同一个客户端一段时间内被定向至同一个后端主机

least_conn: 最少连接那个后端主机

lc,wlc

proxy: 代理模块,

proxy_pass: url 请求代理至某一后端

proxy可以定义许多属性和功能,比如定义缓存,基于内存和磁盘来建立缓存,,,,而且可以定义对于不同响应内容的缓存时长

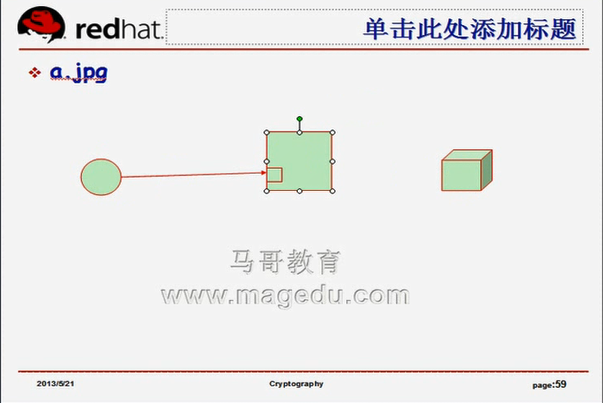

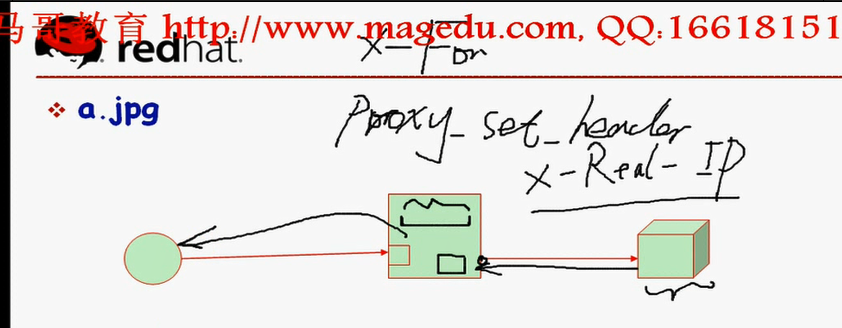

nginx一手拖两家,如果没有缓存,一般定向至后端服务器,,如下图,,如果客户端请求的a.jpg到nginx,nginx去后端取,后端服务器没有,就会返回错误代码给客户端,,,,,,,如果用户请求的/images(nginx中只定义了/bbs /php),,此时nginx根本不会向后转发,此时nginx封装错误页面响应给客户端(404 403等,用户请求错误,返回4开头的代码)(502等,服务器自己错误,返回5开头的代码),,,所以这些响应给客户端的是nginx代理服务器生成的

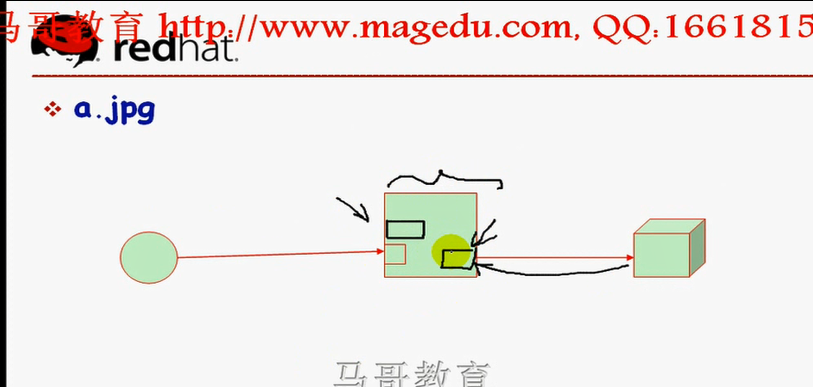

如下图在nginx代理时,从客户端到后端服务器一般是异步的,(如果是同步,请求报文是一连串进来的,报文到nginx所在计算机网卡的时候,是一串过来的,nginx服务器是收到报文的首部之后,就知道要访问什么了?nginx服务器不做任何处理,直接将内容转发至后端,,,,,由后台服务器自己响应,响应完之后,返回给nginx,再返回给客户端)

如下图,(异步就是,nginx接收客户端报文,存到nginx自己的内存当中,因为连接比较多,nginx服务器会一个个的拿出来,转给后端服务器进行处理,,,,,,后端服务器返回给nginx,先暂存在nginx本地,而后再封装,响应给客户端),,,,前端客户端在异步模型下,不能达到后端,,,它的所有连接的建立都是跟nginx进行的,,,,如果nginx处理连接的能力比较强的话,会大大的减轻后端服务器连接上的压力,,这是nginx 的优势

像squid服务器,向后端转发时是同步的,因此将前端压力转到后端了,这是它的劣势

如下图,nginx的异步转发,可以将报文转到后端服务器之前,做很多处理,比如加X-Real-IP,将客户端真正地址发给后端web服务器,

指令是 Proxy_set_header X-Real-IP $remote_addr,,,还有一个X-Forward-For指令,,,,Proxy_set_header 是向后端web服务器转发请求时添加的

后端web服务器,把响应发给nginx,nginx可以进行处理,添加首部,也有个指令 addheader (向前端客户端响应时添加的),,,addheader X-Via(谁帮你响应的????), addheader X-Cache(缓存状态信息,说明有没有命中)

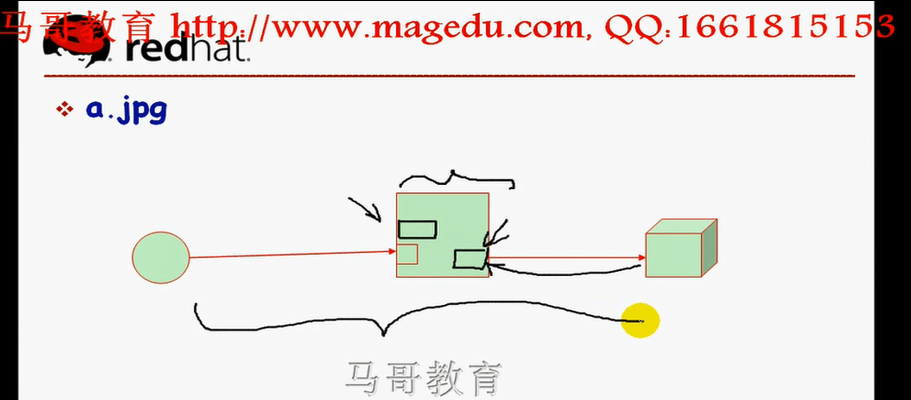

如下图,正是因为有异步模型的存在,使得有一个要求,在使用代理模型的时候,,,,,,nginx中有内存来暂存客户端请求过来的会话,,,还有服务器端的响应到nginx的时候,先暂存到nginx本地内存,而后封装后响应给客户端,,,,,,,,两个内存空间倒底多大?这个暂存内存调大,会存更大内容,,,,,但调的太大的话,内存不够用,系统可能崩溃,,,,,,反向代理上,有很多参数可以调整,比如这些调整内存的大小,,,,,,,,nginx调优的重要内容之一,无非就是调整cache或buffer,

nginx中 cache和buffer比较多,比如打开文件的cache,打开日志的cache,fastcgi的cache,reverse proxy的cache,,,,

nginx对内存的占用率比较节约,这些空间需要根据自己的实际需要和业务能力进行调整,,

这些调整还包括gzip压缩的buffer

指令太多,无法全部介绍,,,,,,,,将来如果需要用到调整的话,比如观察一下内存使用情况,发现压缩本身的执行速度不够快,可以把gzip的buffer调大一点,,当然不是越大越好,,,,,,,,,,,,

如下图,,这就是具有负载功能,反向代理的nginx所具备的能力,,,,,,,,,事实上,nginx是众多能够工作在7层,主要是对于http协议实施反向代理的一种负载均衡器,(反向代理服务器)

nginx可以反向代理memcached,除了httpd协议,还可以支持众多的tcp协议,

haproxy类似于nginx的反向代理功能,它有一定的高可用功能,,,,,不是自己提供高可用,而是说将用户请求转到后端服务器时,可以检查后端服务器的健康状况,,可以自动剔除不正常的应用的,自动剔除错误的服务器,错误的服务器正常后,还能加回来, nginx等几乎所有的反向代理都有这种能力

nginx-->淘宝版本tengine,也是开源的,功能比nginx多,tengine可以实现动态模态加载,apache也可以实现动态模态加载(apache装上后,可以单独编译模块,让apache装载就可以了),,,早期nginx虽然是模块化的,但需要在编译nginx时就要编译进来,否则无法使用,,,,,,tengine命令行支持更多命令选项,比nginx更简单,更明晰,,,

现在 http://tengine.taobao.org/ 看不到如下的截图,马哥当时是看到的

nginx.conf

worker_process 定义进程个数 配置多少个取决于CPU密集(不跟cpu绑定,与cpu数目相等 1 倍 ) 还是IO密集(cpu个数的1.5倍,当然要尽可能的发挥io能力) 我们可以将这些cpu进程绑定在cpu上,建立所谓的亲缘性(一个进程有多个请求,绑定进程到cpu,这样不用进程切换,发挥cpu最大性能)

tengine 可以自动选择最佳进程?????数目,不用配置,自动建立亲缘性

http://tengine.taobao.org/documentation.html tengine文档

现在 http://tengine.taobao.org/documentation.html 看不到如下的截图,马哥当时是看到的

session_sticky模块,会话绑定,会话粘性,

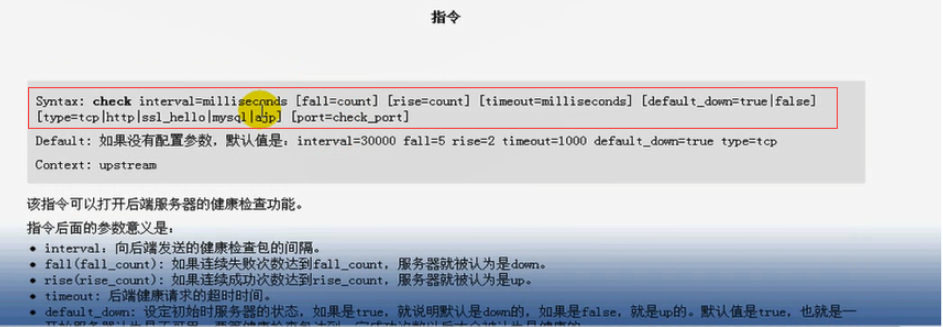

如下图,健康检查模块功能

tengine 那个进程仍然叫nginx

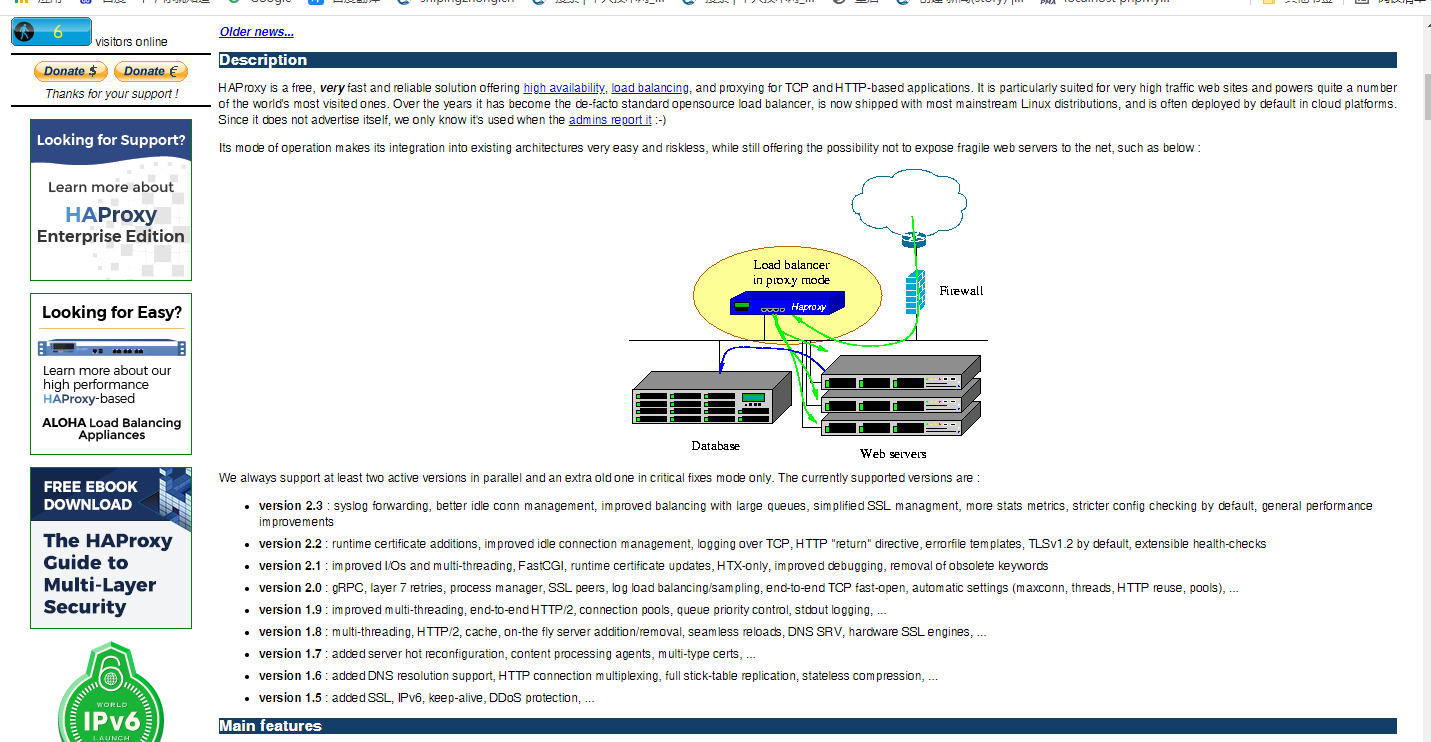

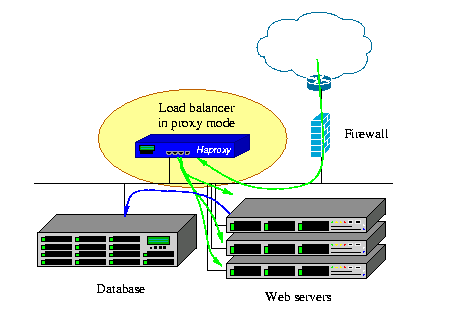

haproxy 虽然名称上是ha, 但是它是一个load balancer 负载均衡器

haproxy 是工作在7层的反向代理服务器

如下图,反向代理两种模式

lvs,工作在内核的,反向代理转发 其实有纯粹工作在内核的web服务器,性能强,工作特性比较差

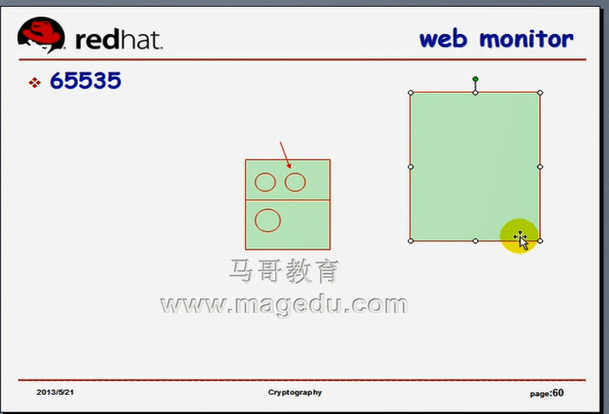

haproxy,nginx工作在用户空间的,,,,,,上下文切换,用户空间到内核空间的转换不可避免,,,,,,系统调用,模式空间转换??????这些操作不可避免,模式空间转换是相当占用资源的 haproxy,nginx无法摆脱打开最大套接字文件的限定,,,,一个计算机最大打开65535 (65536)个套接字文件 我们在实现代理的时候,最大的并发连接数不会超过65535(事实上,其中很多被其它进程占用了),,,并发连接数达几万就不错了,nginx三四万个应该没有问题,最高有人优化到五万个,,,,haproxy也无法突破这个限定,但是lvs突破了,

lvs性能大大超过 haproxy,nginx,,,但是lvs配置复杂,非常简陋,,,所以用到丰富特性,用到7层功能的修改的话,haproxy,nginx,是我们的首选,,,只要并发量不大的话,haproxy,nginx,就行,,,,,

haproxy自带web监控接口,web monitor,,,,装上haproxy,打开一个web页面,连到haproxy,能显示出当前有多少个连接,每一个后端服务器建立了多少个连接,每一个后端服务器当前是否健康,每一个后端服务器最大允许接受多少个连接等等,,,在界面上,可以手动发送控制指令,可以手动down掉某个后端服务器,,,,,,haproxy提供更强大的,更易于管理的界面

haproxy的转发能力不如lvs,,,并发量特别大,就要用lvs了

否则很多公司用haproxy,在转发能力上,在转发特性定制上,haproxy比nginx有更强的可定制性

haproxy在转发同样数量的连接上,比nginx需要更多资源(包括内存,cpu等)

haproxy也是基于事件驱动,单一进程来响应众多连接的服务

如下图,,,,nginx可以启动多个worker,但是haproxy完全使用一个进程来响应,来向后代理,

虽然haproxy可以开启在多进程模式下,但是不建议这么做

一、HAProxy简介

HAProxy提供高可用性(后端 real server (upstream server)的健康状况检查)、负载均衡以及基于TCP和HTTP应用的反向代理,支持虚拟主机,它是免费、快速并且可靠的一种解决方案。HAProxy特别适用于那些负载特大的web站点,这些站点通常又需要会话保持或七层处理(添加首部,修改首部,甚至在协议上作一些更多的更改等)。HAProxy运行在时下的硬件上,完全可以支持数以万计的并发连接。并且它的运行模式使得它可以很简单安全的整合进您当前的架构中, 同时可以保护你的web服务器不被暴露到网络上。

HAProxy实现了一种事件驱动、单一进程模型(无非发挥多cpu的优势,一般两颗cpu就够了,一颗给haproxy,一颗给所有其它进程),此模型支持非常大的并发连接数。多进程或多线程模型受内存限制 、系统调度器限制以及无处不在的锁限制,很少能处理数千并发连接。事件驱动模型因为在有更好的资源和时间管理的用户端(User-Space) 实现所有这些任务,所以没有这些问题。此模型的弊端是,在多核系统上,这些程序通常扩展性较差。这就是为什么他们必须进行优化以 使每个CPU时间片(Cycle)做更多的工作。

————百度百科

HAProxy是免费、极速且可靠的用于为TCP和基于HTTP应用程序提供高可用、负载均衡和代理服务的解决方案,尤其适用于高负载且需要持久连接或7层处理机制的web站点。

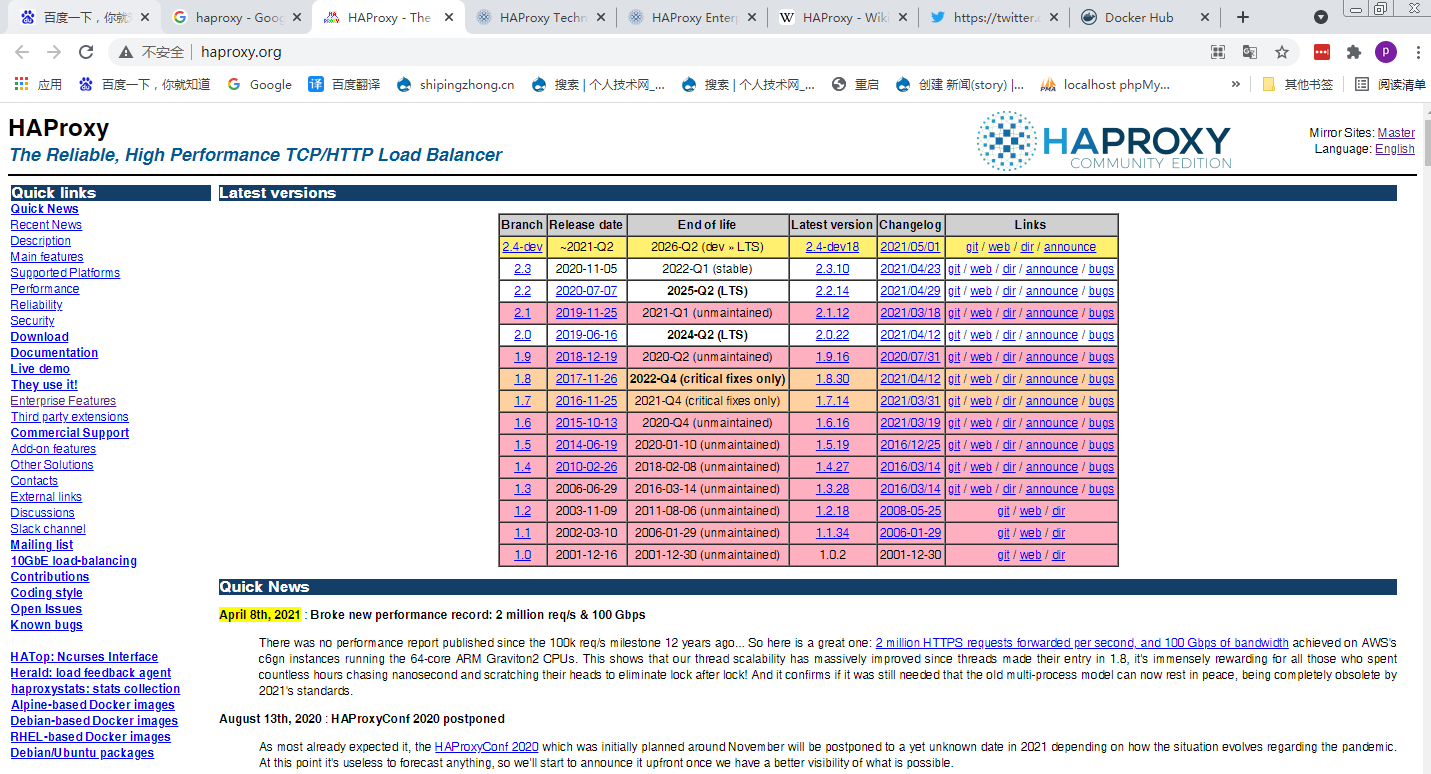

HAProxy目前主要有两个版本:

1.4与1.3的着眼点侧重点各不相同,众多企业使用1.4的版本,

1.4——提供较好的弹性:衍生于1.2版本??,并提供了额外的新特性,其中大多数是期待已久的。

客户端侧的长连接(client-side keep-alive)

TCP加速(TCP speedups)

响应池(response buffering)

RDP协议

基于源的粘性(source-based stickiness)

更好的统计数据接口(a much better stats interfaces)

更详细的健康状态检测机制(more verbose health checks)

基于流量的健康评估机制(traffic-based health)????

支持HTTP认证

服务器管理命令行接口(server management from the CLI)

基于ACL的持久性(ACL-based persistence)

日志分析器

1.3——内容交换和超强负载:衍生于1.2版本??,并提供了额外的新特性。

内容交换(content switching):基于任何请求标准挑选服务器池;

ACL:编写内容交换规则?????;

负载均衡算法(load-balancing algorithms):更多的算法支持;

内容探测(content inspection):阻止非授权协议????;

透明代理(transparent proxy):在Linux系统上允许使用客户端IP直接连入服务器;

内核TCP拼接(kernel TCP splicing):无copy方式在客户端和服务端之间转发数据以实现数G级别的数据速率;

分层设计(layered design):分别实现套接字、TCP、HTTP处理以提供更好的健壮性、更快的处理机制及便捷的演进能力;

快速、公平调度器(fast and fair scheduler):为某些任务指定优先级可实现理好的QoS;

会话速率限制(session rate limiting):适用于托管环境;

支持的平台及OS:

x86、x86_64、Alpha、SPARC、MIPS及PARISC平台上的Linux 2.4;

x86、x86_64、ARM (ixp425)及PPC64平台上的Linux2.6;

UltraSPARC 2和3上的Sloaris 8/9;

Opteron和UltraSPARC平台上的Solaris 10;

x86平台上的FreeBSD 4.1-8;

i386, amd64, macppc, alpha, sparc64和VAX平台上的OpenBSD 3.1-current;

若要获得最高性能,需要在Linux 2.6或打了epoll补丁的Linux 2.4上运行haproxy 1.2.5以上的版本(因为它们支持事件驱动)。haproxy 1.1l?????默认使用的polling系统为select(),其处理的文件数达数千个(好像最多支持1024个,超出1024个性能特差,apache甚至直接拒绝了)时性能便会急剧下降。1.2和1.3版本默认的为poll(),在有些操作系统上可能也会有性能方面的问题,但在Solaris上表现相当不错。HAProxy 1.3在Linux 2.6及打了epoll补丁的Linux 2.4上默认使用epoll,在FreeBSD上使用kqueue,这两种机制在任何负载上都能提供恒定的性能表现。

在较新版本的Linux 2.6(>=2.6.27.19)上,HAProxy还能够使用splice()系统调用在接口间无复制地转发任何数据,这甚至可以达到10Gbps的性能。

基于以上事实,在x86或x86_64平台上,要获取最好性能的负载均衡器,建议按顺序考虑以下方案。

Linux 2.6.32及之后版本上运行HAProxy 1.4;

打了epoll补丁的Linux 2.4上运行HAProxy 1.4;

FreeBSD上运行HAProxy 1.4;

Solaris 10上运行HAProxy 1.4;

性能

HAProxy借助于OS上几种常见的技术来实现性能的最大化。

单进程、事件驱动模型显著降低了上下文切换(上下文切换啥意思?是不是就是进程切换)的开销及内存占用。

O(1)事件检查器(event checker)允许其在高并发连接中对任何连接的任何事件实现即时探测??????。

在任何可用的情况下,单缓冲(single buffering)机制(将单缓冲在各个模块之间实现共享)能以不复制任何数据的方式完成读写操作 (类似于内存映射),这会节约大量的CPU时钟周期及内存带宽;

借助于Linux 2.6 (>= 2.6.27.19)上的splice()系统调用,HAProxy可以实现零复制转发(Zero-copy forwarding)(内容不作任何复制 ,从内核空间直接到用户空间????而后直接转发出去了,有点类似于sendfile,,,,,,,,,linux操作系统内核,内部带宽也是有限的,不考虑硬件的特性, linux内核自己,在内部实现的数据处理,每秒钟只能达到10G左右,,,,,,,,频繁的在linux内部复制数据的话,它也会占据大量的内核带宽的),在Linux 3.5及以上的OS中还可以实现零复制启动(zero-starting)(不复制任何数据,就可以启动起来了?????);

MRU内存分配器在固定大小的内存池中可实现即时内存分配(比 slab allocator更强),这能够显著减少创建一个会话的时长;(每一个用户连接接进来,我们必须要给它创建一个内存空间给它用于缓冲的,保存这个用户会话的相关信息,,,,,,,haproxy使用的是MRU的内存分配器)

树型存储:侧重于使用作者多年前开发的弹性二叉树,实现了以O(log(N))的低开销来保持计时器命令、保持运行队列命令及管理轮询及最少连接队列??????;(O(log(N)): 这个算法,数据量变大了,性能还是有所降低的,O(log(N))是仅次于O(1)的一种高性能的评估结果)

优化的HTTP首部分析:优化的首部分析功能避免了在HTTP首部分析过程中重读任何内存区域??????;(haproxy在优化的HTTP首部分析上有些地方比nginx更强,,,但是分析的越多,将来越占用资源,)

精心地降低了昂贵的系统调用,大部分工作都在用户空间完成,如时间读取、缓冲聚合及文件描述符的启用和禁用等??????;大部分工作不再执行系统调用,,,,,,,,在用户空间完成以后,执行最后一次系统调用,由内核通过TCP/IP协议站向外发送就OK了,

所有的这些细微之处的优化实现了在中等规模负载之上依然有着相当低的CPU负载,甚至于在非常高的负载场景中,5%的用户空间占用率和95%的系统空间占用率也是非常普遍的现象,这意味着HAProxy进程消耗比系统空间消耗低20倍以上。因此,对OS进行性能调优是非常重要的。即使用户空间的占用率提高一倍,其CPU占用率也仅为10%,这也解释了为何7层处理对性能影响有限这一现象。由此,在高端系统上HAProxy的7层性能可轻易超过硬件负载均衡设备?????。

在生产环境中,在7层处理上使用HAProxy作为昂贵的高端硬件负载均衡设备故障时的紧急解决方案也时长可见。硬件负载均衡设备在“报文”级别处理请求,这在支持跨报文请求(request across multiple packets)有着较高的难度,并且它们不缓冲任何数据,因此有着较长的响应时间?????。对应地,软件负载均衡设备使用TCP缓冲,可建立极长的请求,且有着较大的响应时间?????。

可以从三个因素来评估负载均衡器的性能:

会话率: 单位时间内完成的会话数,

会话并发能力: 同时持有的会话数

数据率:单位时间内所能够实现的数据交换的能力

二、配置HAProxy

2.1 配置文件格式

HAProxy的配置处理3类主要参数来源:

——最优先处理的命令行参数?????,传递给haproxy的那些参数

——“global”配置段,用于设定全局配置参数;分为两类

跟服务定义(进程定义)相关的

跟优化相关的

—— proxy相关配置段,真正实现反向代理的配置段, 如

“defaults”、为后面的“listen” "frontend”backend”设置默认值段,当然不是后面三个都能使用每一个默认值;;;;;;;defaults可以定义某一类服务使用listen,,,另一类服务使用 frontend,backend

“listen”、监听哪个端口,监控在某端口后,(像nginx一样,定义一个server,监听在80上,真正用户请求时,通过proxy_pass代理至后端的,proxy的listen类似于nginx的server功能,首先定义监听的端口,其次要说明白地址的端口请求要转发至哪些后端服务器上,直接在内部就可以实现负载均衡的)实现了将前端用户的请求通过某个套接字端口关联至后端一组上游服务器,如下图,,,,listen就相当于前端后端放在一块了,揉合在一起了,,,,,来自于用户的对于某个listen的请求转发至哪些后端就是特定的了

"frontend”前端,,单独定义前端,,, 可以先定义监听在哪些端口上,监听以后到底可以代理到哪些后端服务器,不定义?????,,,可以定义一组后端,想要哪些后端就关联到哪些后端,,,,,,(而listen是整合到一块的),,,,,,,,这里单独定义frontend,里面的 default_backend 明确说明将自己这个监听和哪些后端服务器建立关联关系,并且能够实现根据某些特性,某些判断条件选择合适的后端????,比listen更有灵活性,有一定程度的复杂度吧,将来排错起来困难????

“backend”后端,,单独定义后端,

2.2 时间格式

haproxy的计时器,默认是以毫秒为单位的,

一些包含了值的参数表示时间,如超时时长。这些值一般以毫秒为单位,但也可以使用其它的时间单位后缀。

us μs: 微秒(microseconds),即1/1000000秒;

ms: 毫秒(milliseconds),即1/1000秒;

s: 秒(seconds);

m: 分钟(minutes);

h:小时(hours);

d: 天(days);

2.3 例子 下面这个例子没有使用listen

下面的例子配置了一个监听在所有接口的80端口上HTTP proxy服务,它转发所有的请求至后端监听在127.0.0.1:8000上的"server"。

global

daemon #以守护进程方式运行

maxconn 25600 #最大连接数

defaults #默认

mode http #代理的是http模式,,,可以使用tcp来代理其它协议???比如基于tcp的mysql服务

timeout connect 5000ms #建立连接的超时时间为5秒

timeout client 50000ms #客户端空闲连接,断开时间是50秒

timeout server 50000ms #服务器端空闲连接,断开连接,超时时间是50秒

frontend http-in #定义了一个前端 http-in是前端的名称,可以自己取,通常是acsi的字符

bind *:80 #使用bind,不能使用listen 监听端口

default_backend servers #有人访问我们的80端口,使用默认后端是 servers,servers是backend 那边定义的

backend servers #定义了一个后端 servers是后端的名称

server server1 127.0.0.1:8080 maxconn 32 #这里server是关键字,server1 是名称 127.0.0.1:8080是套接字 最大并发连接是32

haproxy有个监控接口,基于web服务的gui监控接口,这个接口,默认情况下,可以自己定义在哪一个套接字向外提供,不是通过80端口向外提供的(比如mysql-proxy,提供的代理是4040,提供的监控管理接口是4041),,,,haproxy提供代理的是一个接口,而对haproxy自身实现基于web gui的查看,得额外定义一个接口

2.4 全局配置

“global”配置中的参数为进程级别的参数,且通常与其运行的OS相关。

* 进程管理及安全相关的参数 当然不是每一个都需要提供,一般至少要提供daemon,常见的有log,pidfile, stats,偶尔对安全性比较关注,可以使用chroot

- chroot <jail dir>:修改haproxy的工作目录至指定的目录并在放弃权限之前执行chroot()操作??????,可以提升haproxy的安全级别,不过需要注意的是要确保指定的目录为空目录且任何用户均不能有写权限;;;;;;;我们如果让它运行在很小的很简单的放在一个独立的假根目录里面,将来就算有人攻破了我们的进程,它也只能在假根里面转悠,不会真正危害我们的操作系统的

- daemon:让haproxy以守护进程的方式工作于后台,其等同于“-D”选项的功能,当然,也可以在命令行中以“-db”选项将其禁用;

- gid <number>:以指定的GID运行haproxy,建议使用专用于运行haproxy的GID,以免因权限问题带来风险;组id号 用它可以不用group了吧

- group <group name>:同gid,不过指定的组名;指定组名称的 用它可以不用gid了吧

- log <address> <facility> [max level [min level]]:定义全局的syslog服务器,最多可以定义两个;global中的log是定义全局日志的,,,因为listen frontend backend????定义好几组代理服务器,(后端服务器????或者我们专门定义的反向代理,可以继承之,也可以覆盖之),,,,,当然我们也可以不定义全局的log,,,,,,,,,<address>哪个服务器,我们专门的日志服务器系统,,,,,, <facility>设施 ,,,,,max level 最大级别,,比较低的级别,,比这个级别高的才会记录,,,,,,,,,,min level最小级别,可以省略

- log-send-hostname [<string>]:在syslog信息的首部添加当前主机名,可以为“string”指定的名称,也可以缺省使用当前主机名; 记录日志的时候是否记录主机名,,,,,,,如果使用统一的集中的日志文件系统(日志服务器)的话,必须要说明白是哪个服务器发来的

- nbproc <number>:指定启动的haproxy进程个数,只能用于守护进程模式的 haproxy (没有加daemon,就不能使用nbproc );默认只启动一个进程,鉴于调试困难等多方面的原因,一般只在单进程,,仅能打开少数文件描述符的场景中才使用多进程模式????; number of process ,,,,,,,,使用多个的话,将来追踪错误信息非常困难,调试非常困难,,,,单进程性能足够高,使用多进程不能发挥优势

- pidfile:pid file 进程pid文件

- uid:以指定的UID身份运行haproxy进程;用户id号 用它可以不用user了吧

- ulimit-n:设定每进程所能够打开的最大文件描述符数目,默认情况下其会自动进行计算,因此不推荐修改此选项;

limit有个命令叫ulimit,,,,,,,,,,, linux上限定一个独立的进程最大打开1024个文件描述符,当haproxy实现反向代理的时候,每一个用户连接都需要一个套接字,一个进程只能打开一个文件描述符的话??????所以这样子就导致它无法打开更多的套接字文件描述符,就无法接受更多的连接数,我们应该让运行haproxy进程的用户能够打开更多的文件,haproxy尽可能的让所有的设置在用户这边完成,所以ulimit-n可以手动在配置文件中调整了最大文件描述符数目,但是默认情况下其会自动进行计算,因此不推荐修改此选项

[root@master ~]# ulimit -n #显示单进程可以打开的最大文件数目的

1024

[root@master ~]#?

- user:同uid,但使用的是用户名;指定用户名称的 用它可以不用uid了吧

- stats:通常在后端进行定义,所以这里完全不用定义了

- node:定义当前节点的名称,用于HA场景中多haproxy进程共享同一个IP地址时;区别一下正在服务的节点是谁??????

- description:当前实例的描述信息;

* 性能调整相关的参数 一般与连接缓冲区相关吧

- maxconn <number>:设定每个haproxy进程所接受的最大并发连接数,其等同于命令行选项“-n”;“ulimit -n”自动计算的结果正是参照此参数设定的; 最大连接数

- maxpipes <number>:haproxy 使用pipe完成基于内核的tcp报文重组(为什么要重组?ip是不是有分片?????),此选项则用于设定每进程所允许使用的最大pipe个数;每个pipe会打开两个文件描述符,因此,“ulimit -n”自动计算时会根据需要调大此值;默认为maxconn/4,其通常会显得过大;最大管道数

- noepoll:在Linux系统上禁用epoll机制;#这些no表示不使用某种事件驱动框架的,,,,,,,,一般来讲,只要支持,都不应该禁用的

- nokqueue:在BSE系统上禁用kqueue机制;

- nopoll:禁用poll机制;

- nosepoll:在Linux禁用启发式epoll机制;

- nosplice:禁止在Linux套接字上使用内核tcp重组,这会导致更多的recv/send系统调用;不过,在Linux 2.6.25-28系列的内核上,tcp重组功能有bug存在;#一般不要禁用,,Linux 2.6.25-28系列必须要禁用,,红帽6上是2.6.32,完全可以启用splice,splice本身可以实现零复制转发的,这是性能提升的一种机制

- spread-checks <0..50, in percent>:在haproxy后端有着众多服务器的场景中,在精确的时间间隔后统一对众服务器进行健康状况检查可能会带来意外问题;此选项用于将其检查的时间间隔长度上增加或减小一定的随机时长;;;haproxy,nginx,lvs的ldircectord?都能够实现对后端服务器的健康状况检查,,,,如果后端100台服务器,2秒钟检要一次,结果到第2秒的时候,要发出100个检测报文(探测报文),占的带宽大,正常服务,正常转发会受影响,,,,,, spread-checks就是实现这样的功能,它将向real server健康状况检查的报文分散发送,而不是精确时间发送的,,,,,,<0..50, in percent>比如你可以以25%,,,比如定义个2秒间隔,2秒*25%得到的结果,可以提前这个长度或者延迟这个长度,,在这个范围内随机找一个值进行转发,,,,这样探测报文就不会影响正常的服务了.

- tune.bufsize <number>:设定buffer的大小,同样的内存条件小,较小的值可以让haproxy有能力接受更多的并发连接,较大的值可以让某些应用程序使用较大的cookie信息;默认为16384,其可以在编译时修改,不过强烈建议使用默认值;设定缓冲区大小

- tune.chksize <number>:设定检查缓冲区的大小,单位为字节;更大的值有助于在较大的页面中完成基于字符串或模式的文本查找,但也会占用更多的系统资源;不建议修改;设定检查缓冲区大小;;;;;;;;;我们向后转发的时候,haproxy可以实现报文中的某些字符的查找,根据某些条件向后转发的,要实现条件式的转发,必须要看看对方满不满足我们的条件,在协议报文中实现文本搜索查找的,,,,,,,要完成文本查找,得在一定的工作车间workshop,一定的工作环境中查找,而这是定义查找的工作环境是多大的

- tune.maxaccept <number>:设定haproxy进程内核调度运行时一次性可以接受的连接的个数,较大的值可以带来较大的吞吐率,默认在单进程模式下为100,多进程模式下为8 (为何差别太大,因为多进程要负载均衡了,假如多进程为100个,人家一共就50个请求,你这一个进程会全部接进来,其它的进程就会闲了,,就不能负载均衡了,,,,,,当然多进程我们不建议使用,,,),设定为-1可以禁止此限制;一般不建议修改;;;;;;;;;;;;;;一次性可以接受的连接个数,如下图,haproxy运行的时候,这个进程不一定每一个时刻在cpu上运行,假设只有一颗cpu,本来我们的内核正调度其它进程执行的,这个进程没运行,就不能接受用户连接了,过一会儿内核调度这个进程运行了,此时,客户端有200个等待连接,一批只能接进来100个,后面的100个连接还得等待,,,当100个接进来之后,内核一调度,调度后,这个进程又睡眠了,这个进程下次醒来,再接进后面的100个

- tune.maxpollevents <number>:设定一次系统调用可以处理的事件最大数,默认值取决于OS;其值小于200时可节约带宽,但会略微增大网络延迟,而大于200时会降低延迟,但会稍稍增加网络带宽的占用量;;;;;;;;;;;;;;;;;;;;;;;;;在基于事件驱动模型的时候,它每一次可以实现多少个回调,,,,也就是一次系统调用可以完成多少个事件的查看,比如作为进程来讲,如下图,一个进程可以响应n个连接,现在接进来1万个连接,每个连接请求的内容倒底有没有准备好,是通过内核与其它后端主机联系的,到底准备好了没有?我们要通过系统调用event事件驱动来看看准备好了没有,于是进程向我们的事件驱动模型发起系统调用????,,,事件驱动模型就会给进程通知了(我总感觉,事件准备好了,会主动通知的),,,一次可以查看多少个的,,,,,一般最大值为256个,

- tune.maxrewrite <number>:设定为首部重写或追加而预留的缓冲空间,建议使用1024左右的大小;在需要使用更大的空间时,haproxy会自动增加其值;

- tune.rcvbuf.client <number>:

- tune.rcvbuf.server <number>:设定内核套接字中服务端或客户端接收缓冲的大小,单位为字节;强烈推荐使用默认值;

- tune.sndbuf.client:

- tune.sndbuf.server:

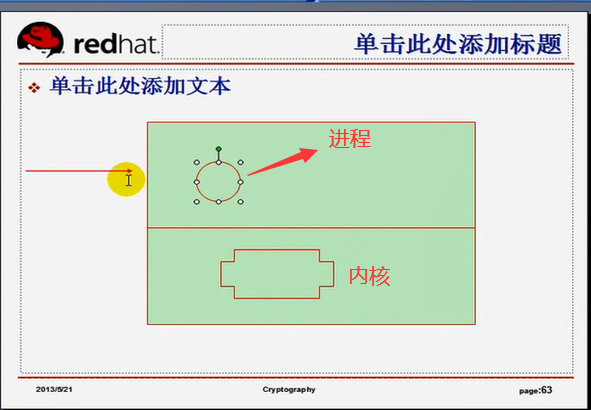

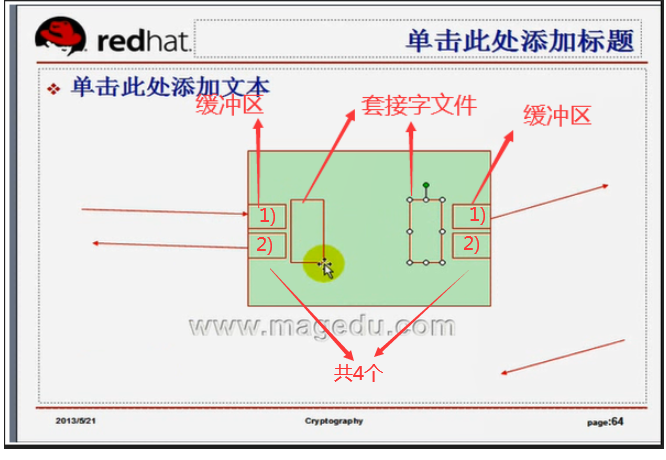

如下图,反向代理时,一个连接打开4个套接字文件,面向客户端的两个(接收缓冲,发送缓冲),面向后端服务器端相关两个(接收缓冲,发送缓冲),一手托两家,,,,,,,,,,,,nginx上计算最大客户端连接数的时候,要除以4,nginx最大接受多少的并发连接(单个进程能够处理的连接数*进程个数),,,,nginx基于web server来工作的话,所有能够容纳的连接数就是直接是相同的结果?????,,如果工作在反向代理模型下,就是除以4??除以4才是真正所能够容纳的客户端数,因为现在的浏览器都是双线程的,所以需要一进一出两个线程,,,,,,,事实上缓冲是两个,但是文件只有一个(一个套接字文件),,,,,,,,,所以一进一出,两个连接,它需要的文件是两个,但是缓冲是4个,,,,,,,, 为了维持客户端连接需要一个文件,为了维持服务器端连接需要一个文件,,,,,,,,,,,,,,,,,,,,,而我们要接受客户端的请求,需要一个内存空间(接收缓冲区),我要发送响应给客户端,也需要一个内存空间(发送缓冲区),,,,,,,,代理服务器与后端服务器端通信也是同理的

* Debug相关的参数

- debug 调试??????

- quiet 静默模式

2.5 代理

代理相关的配置可以如下配置段中。 4个代理段

#需要 name 来定义

- defaults <name> #仅定义一个

- frontend <name> #可定义多个

- backend <name> #可定义多个backend

- listen <name> #可定义多个

“defaults”段用于为所有其它配置段提供默认参数,这配置默认配置参数可由下一个“defaults”所重新设定。????既然有下一个,说明什么?说明defaults可以定义多个.

“frontend”段用于定义一系列监听的套接字,这些套接字可接受客户端请求并与之建立连接。 #主要定义在哪些地址,端口上接受客户端请求的,frontend还可以定义,把客户端请求接进来之后,后续作一堆的分析和处理,比如去掉某个首部,替换掉某个首部等,,在frontend上面定义关联到哪些backend上,可以使用ACL明确定义哪一类客户端定义到哪一类(个)backend???

“backend”段用于定义一系列“后端”服务器,代理会将对应客户端的请求转发至这些服务器。#定义后端服务器,然后把 frontend与 backend关联起来就可以了

“listen”段通过关联“前端”和“后端”定义了一个完整的代理,通常只对TCP流量有用?????。#直接定义关联前端和后端,定义一个完整代理,,,,,一个listen就是一个独立的frontend,backend组合

所有代理的名称只能使用大写字母、小写字母、数字、-(中线)、_(下划线)、.(点号)和:(冒号)。此外,ACL名称会区分字母大小写。

三、配置文件中的关键字参考 (以下是定义在代理段的关键字参数?)

3.1 balance #负载均衡

#backend 可以定义多个server, 到底使用哪种方式进行调度?????可以定义负载均衡算法,定义调度方法

balance <algorithm> [ <arguments> ]

balance url_param <param> [check_post [<max_wait>]]

定义负载均衡算法,可用于“defaults”、“listen”和“backend”。#不能用在frontend,因为前端那边无服务器,用不到调度算法

<algorithm>用于在负载均衡场景中挑选一个server,其仅应用于持久信息不可用的条件下或需要将一个连接重新派发至另一个服务器时?????。支持的算法有:

roundrobin:基于权重进行轮叫,在服务器的处理时间保持均匀分布时,这是最平衡、最公平的算法。此算法是动态的,这表示其权重可以在运行时进行调整,不过,在设计上,每个后端服务器仅能最多接受4128个连接;#可以在server上指定权重,与nginx一样,,,它是动态的,有点类似于lc(leastconn 最小连接),,,,使用http时,最好使用roundrobin

static-rr:基于权重进行轮调,与roundrobin类似,但是为静态方法,在运行时调整其服务器权重不会生效;不过,其在后端服务器连接数上没有限制;

leastconn:新的连接请求被派发至具有最少连接数的目的后端服务器;在有着较长时间会话的场景中推荐使用此算法,如LDAP、SQL等,其并不太适用于较短会话的应用层协议,如HTTP;此算法是动态的,可以在运行时调整其权重;#跟权重也有关系,????

source:将请求的源地址进行hash运算,并由后端服务器的权重总数相除后派发至某匹配的服务器;这可以使得同一个客户端IP的请求始终被派发至某特定的后端服务器;不过,当服务器权重总数发生变化时,如某服务器宕机或添加了新的服务器,许多客户端的请求可能会被派发至与此前请求不同的服务器;常用于负载均衡无cookie功能的基于TCP的协议;其默认为静态 (不是说调度方法是静态的?????,而是说这些方法它的某些参数不能在运行时修改,即使修改也不会生效,除非重启haproxy,),不过也可以使用hash-type修改此特性;##需要有前端与后端建立关联关系,最好使用source,类似于nginx的ip_hash

uri:对URI的左半部分(“问题”标记之前的部分 比如 http://a.cn/aa.php?x=1&y=2 这里的问号之前的部分即 /aa.php )或整个URI进行hash运算,并由服务器的总权重相除后派发至某匹配的服务器 ;这可以使得对同一个URI的请求总是被派发至某特定的服务器,(服务器增减的话,服务器总权重就变了,服务器派发机制会抖动的) 除非服务器的权重总数发生了变化;此算法常用于代理缓存或反病毒代理以提高缓存的命中率;需要注意的是,此算法仅应用于HTTP后端服务器场景;其默认为静态算法,不过也可以使用hash-type修改此特性; (hash-type有两类,动态和静态,,,,,,使用不同的hash-type可以变化其功用的,,有些hash-type运行时可调整的,有些是不可以调整的,) #比如修改权重,会立即生效的,否则的话,修改权重没有意义,它不会改的,这叫动态?????

url_param:通过<argument>为URL指定的参数在每个HTTP GET请求中将会被检索;如果找到了指定的参数且其通过等于号“=”被赋予了一个值,那么此值将被执行hash运算并被服务器的总权重相除后派发至某匹配的服务器;此算法可以通过追踪请求中的用户标识进而确保同一个用户ID的请求将被送往同一个特定的服务器,除非服务器的总权重发生了变化;如果某请求中没有出现指定的参数或其没有有效值,则使用轮叫算法对相应请求进行调度;此算法默认为静态的,不过其也可以使用hash-type修改此特性;#难理解,用得不多,马哥不讲

hdr(<name>):对于每个HTTP请求,通过<name>指定的HTTP首部将会被检索;如果相应的首部没有出现或其没有有效值,则使用轮叫算法对相应请求进行调度;其有一个可选选项“use_domain_only”,可在指定检索类似Host类的首部时仅计算域名部分(比如通过www.magedu.com来说,仅计算magedu字符串的hash值)以降低hash算法的运算量;此算法默认为静态的,不过其也可以使用hash-type修改此特性;#难理解,用得不多,马哥不讲 根据http的请求的首部进行转发?偶尔有用

rdp-cookie #难理解,用得不多,马哥不讲 基于rdp协议的cookie进行转发

rdp-cookie(name):#难理解,用得不多,马哥不讲

3.2 bind #绑定监听套接字的(ip+port)

bind [<address>]:<port_range> [, ...] #监听地址和端口(可以一堆端口)

bind [<address>]:<port_range> [, ...] interface <interface> #还可以定义网卡

此指令仅能用于frontend和listen区段,用于定义一个或几个监听的套接字。

backend不需要监听,用不到,只是为了提供服务器组的,所以用不到bind

服务器提供好几个监听端口,好几个listent,好几个frontend,,不能提供默认值,要是提供的话,大家的值都相同了,这是不可以的,?????所以不能用在defaults当中

<address>:可选选项,其可以为主机名、IPv4地址、IPv6地址或*;省略此选项、将其指定为*或0.0.0.0时,将监听当前系统的所有IPv4地址;

<port_range>:可以是一个特定的TCP端口,也可是一个端口范围(如5005-5010),代理服务器将通过指定的端口来接收客户端请求;需要注意的是,每组监听的套接字<address:port>在同一个实例上只能使用一次,而且小于1024的端口需要有特定权限的用户才能使用,这可能需要通过uid参数来定义;

<interface>:指定物理接口的名称,仅能在Linux系统上使用;其不能使用接口别名,而仅能使用物理接口名称,而且只有管理员?????有权限指定绑定的物理接口;

例 listen web #web是名称

bind *:80 #然后指定关联的后端,????????使用 default_backend ??????

3.3 mode # 模式

mode { tcp|http|health } # 能代理tcp协议,http协议,health(实现健康状况检查)

设定实例(每个listen都可以定义成一个实例,这里的实例就是haproxy进程)的运行模式或协议。当实现内容交换时,前端和后端必须工作于同一种模式(一般说来都是HTTP模式),否则将无法启动实例。

tcp:实例运行于纯TCP模式,在客户端和服务器端之间将建立一个全双工的连接,且不会对7层报文做任何类型的检查;此为默认模式,通常用于SSL、SSH、SMTP、MySQL等应用 (非http协议);

http:实例运行于HTTP模式,客户端请求在转发至后端服务器之前将被深度分析,所有不与RFC格式兼容的请求都会被拒绝; #haproxy的重要作用通常就是代理http的,haproxy本来就是web服务的反向代理服务器

health:实例工作于health模式,其对入站请求仅响应“OK”信息并关闭连接,且不会记录任何日志信息;此模式将用于响应外部组件的健康状态检查请求;目前来讲,此模式已经废弃,因为tcp或http模式中的monitor关键字可完成类似功能;

3.4 hash-type

hash-type <method>

定义用于将hash码映射至后端服务器的方法;其不能用于frontend区段;可用方法有map-based和consistent,在大多数场景下推荐使用默认的map-based方法。

map-based:hash表是一个包含了所有在线服务器的静态数组。其hash值将会非常平滑,会将权重考虑在列,但其为静态方法,对在线服务器的权重进行调整将不会生效 (必须要重新建立hash表,即一般需要重启服务器了),这意味着其不支持慢速启动??????。此外,挑选服务器是根据其在数组中的位置进行的,因此,当一台服务器宕机或添加了一台新的服务器时,大多数连接将会被重新派发至一个与此前不同的服务器上,对于缓存服务器的工作场景来说,此方法不甚适用。

consistent:hash表是一个由各服务器填充而成的树状结构;基于hash键在hash树中查找相应的服务器时,最近的服务器将被选中(服务器增减时,权重只是影响其中一部分)。此方法是动态的,支持在运行时修改服务器权重,因此兼容慢速启动?????的特性。添加一个新的服务器时,仅会对一小部分请求产生影响,因此,尤其适用于后端服务器为cache的场景。不过,此算法不甚平滑,派发至各服务器的请求未必能达到理想的均衡效果 (但是命中率很好,,本来命中率好的话,均衡效果就一般的????由此在cache的场景下,consistent必须要定义hash-type 为 consistent,,,否则一般不要定义为 consistent了),因此,可能需要不时的调整服务器的权重以获得更好的均衡性。#一致性hash算法

#hash-type 仅仅是某些算法如source,uri的一个补充属性

3.5 log

log global #使用全局定义

log <address> <facility> [<level> [<minlevel>]] #自己定义

为每个实例启用事件和流量日志,因此可用于所有区段 (defaults frontend backend listen )。

全局段中也有log

每个实例(每个 frontend backend listen )最多可以指定两个log参数,

log global 直接使用全局的配置,,,把日志发到全局定义中的日志中去

不过,如果使用了“log global”且"global"段已经定了两个log参数时???????,多余了log参数将被忽略。

global:当前实例的日志系统参数同"global"段中的定义时,将使用此格式;每个实例仅能定义一次“log global”语句,且其没有任何额外参数;

<address>:定义日志发往的位置,其格式之一可以为<IPv4_address:PORT>,其中的port为UDP协议端口,默认为514;格式之二为Unix套接字文件路径,但需要留心chroot应用及用户的读写权限;

<facility>:可以为syslog系统的标准facility之一;

<level>:定义日志级别,即输出信息过滤器,默认为所有信息;指定级别时,所有等于或高于此级别的日志信息将会被发送;

3.6 maxconn #最大并发连接数

maxconn <conns>

设定一个前端的最大并发连接数,因此,其不能用于backend区段。对于大型站点来说,可以尽可能提高此值以便让haproxy管理连接队列,从而避免无法应答用户请求。当然,此最大值不能超出“global”段中的定义??????。此外,需要留心的是,haproxy会为每个连接维持两个缓冲,每个缓冲的大小为8KB,再加上其它的数据,每个连接将大约占用17KB的RAM空间。这意味着经过适当优化后,有着1GB的可用RAM空间时将能维护40000-50000并发连接。

如果为<conns>指定了一个过大值,极端场景下,其最终占据的空间可能会超出当前主机的可用内存,这可能会带来意想不到的结果;因此,将其设定了一个可接受值方为明智决定。其默认为2000。

3.7 default_backend #用在frontend 当中的 ,明确定义某一个frontend当中所关联的默认的后端是谁

default_backend <backend>

在没有匹配的"use_backend"规则时为实例指定使用的默认后端,因此,其不可应用于backend区段。在"frontend"和"backend"之间进行内容交换时,通常使用"use_backend "定义其匹配规则;而没有被规则匹配到的请求将由此参数指定的后端接收。

<backend>:指定使用的后端的名称;

使用案例:

use_backend dynamic if url_dyn # 如果是 url_dyn (表示url是动态内容,但是是在哪里定义 url_dyn 呢?)就使用dynamic 后端 ( dynamic是后端动态服务器的名称)

use_backend static if url_css url_img extension_img # 如果是 css,img,扩展img就使用 static 后端 ( static 是后端静态服务器的名称)

default_backend dynamic

3.8 server #与nginx的upstream一样, 要定义一堆的backend,backend中有可能有多台服务器,,,,,每个server就是用来定义一个服务器

server <name> <address>[:port] [param*] #name是名称 address是地址 port是端口,可省略,若省略就不做映射?????,,,,,,.,使用用户请求到listen的那个端口(与进来的端口一样,,比如请求进到haproxy的80端口,同样此时请求也转发到后端的80端口)? param* 是健康状况检查的各种参数,nginx中也是这么用的?????

为后端声明一个server,因此,不能用于defaults和frontend区段。只能用在listen,listen本来就是直接关联???也可以用在backend

<name>:为此服务器指定的内部名称,其将出现在日志及警告信息中;如果设定了"http-send-server-name",它还将被添加至发往此服务器的请求首部中;

<address>:此服务器的的IPv4地址,也支持使用可解析的主机名,只不过在启动时需要解析主机名至相应的IPv4地址;

[:port]:指定将连接请求所发往的此服务器时的目标端口,其为可选项;未设定时,将使用客户端请求时的同一相端口;

[param*]:为此服务器设定的一系参数;其可用的参数非常多,具体请参考官方文档中的说明,下面仅说明几个常用的参数;

服务器或默认服务器参数: [param*]有哪些

backup:设定为备用服务器,仅在负载均衡场景中的其它server均不可用于启用此server;# sorry server,其它挂了,它才启用的

check:启动对此server执行健康状态检查,其可以借助于额外的其它参数完成更精细的设定,如: # check 健康状况检查

inter <delay>:???设定健康状态检查的时间间隔,单位为毫秒,默认为2000;也可以使用fastinter和downinter来根据服务器端状态优化此时间延迟; #间隔 fastinter,downinter ( 前面讲过有个检查的偏移时间的,偏移数百分比,偏移数百分比本来就能够实现延迟,,,,,,,我们还可以根据服务器本身的负载来决定应该提前检查,还是延后检查,,,,,,,,fastinter就是提前,在2000毫秒之前检查,,,downinter就是推后,在2000?????毫秒之后检查 )

rise <count>:设定健康状态检查中,某离线的server从离线状态转换至正常状态需要成功检查的次数;#健康状况检查时,它当前是离线的,突然一检查,它上线了,,,,,,检查几次才能确定是否真正上线.检查几次才成功才能最后算成功?nginx也有这个功能????

fall <count>:确认server从正常状态转换为不可用状态需要检查的次数;#从正常时,一检查,不在线,为了避免误杀,再检查一次,,,,,,,,一般从正常到不正常要多检查一次,,,,而从不正常到正常,一般1次就准了(就是rise)

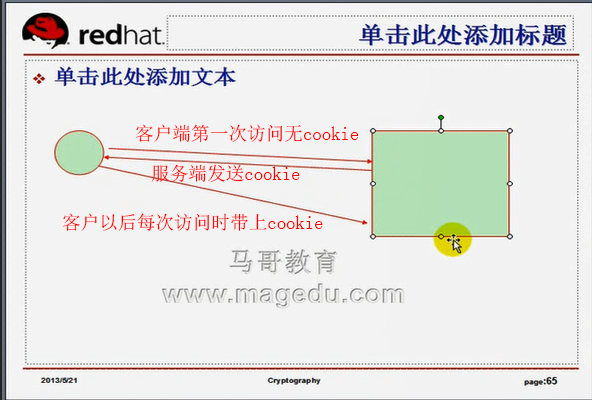

cookie <value>:为指定server设定cookie值,此处指定的值将在请求入站时被检查,第一次为此值挑选的server将在后续的请求中被选中,其目的在于实现持久连接的功能??????;#cookie是用户的身份标识,服务器为了追踪每一个用户,http协议是无状态的,所以用户的两次访问之间服务器是无法识别是同一用户帐号的,,,,,,,为了识别,怎么办?? 如下图,服务器端根据cookie来识别客户端身份,,,,,,,早先设定cookie的时候,会把用户的所有信息保存在用户的cookie里面,如帐号密码等,如果不清cookie,没有正常退出,关机了,一开机,别人拿你的浏览器直接登录你的网站了,,,,因此去公共场所上网的话,要正常退出,正常退出会清理cookie的....为了避免cookie被滥用,现在通常给cookie设定作用域,比如用户访问了好多网站,每一个网站都发cookie,等一会儿打开其中一个网站,只发这一个网站特定的cookie,,,,cookie作用域通常与域名相关或者与域名下的某个uri相关,,,,,,,比如cookie作用域为 magedu.com 或 magedu.com/bbs/,,,,,,cookie的作用域也称为cookie的domain,,,,,,,,,,,,,,,,,,,,,,

maxconn <maxconn>:指定此服务器(应该是后端服务器)接受的最大并发连接数;如果发往此服务器的连接数目高于此处指定的值,其将被放置于请求队列,以等待其它连接被释放;#最大连接数,,, 假如最大2000,一下子进行2500个连接,那么就排队

maxqueue <maxqueue>:设定请求队列的最大长度;#定义排队的最大长度,如果排队再超过这里定义的最大长度,,,,,,,那么就拒绝或者由haproxy来维持会话?????不能往后端服务器上转发的

observe <mode>:通过观察服务器的通信状况来判定其健康状态 (#不再发信息了,,,,此前的正常连接转发给你,只要你能响应,我就认为你是健康的),默认为禁用,其支持的类型有“layer4”和“layer7”,“layer7”仅能用于http代理场景; # haproxy支持的7层协议只有一个http

redir <prefix>:启用重定向功能,将发往此服务器(应该是后端服务器)的GET和HEAD请求均以302状态码响应 () (而且建立重定向到其它服务器?????);需要注意的是,在prefix后面不能使用/,且不能使用相对地址,以免造成循环;例如:

server srv1 172.16.100.6:80 redir http://imageserver.magedu.com check # 到 172.16.100.6:80 的请求转发到http://imageserver.magedu.com 可以直接在server上重定向, 可以理解成服务器的转发

weight <weight>:权重,默认为1,最大值为256,0表示不参与负载均衡??????不参与啥意思??????;

检查方法:

option httpchk

option httpchk <uri>

option httpchk <method> <uri>

option httpchk <method> <uri> <version>:不能用于frontend段,例如: #<version>是协议,是版本

backend https_relay #https_relay是名称

mode tcp #模式TCP协议

#option httpchk OPTIONS * HTTP/1.1\r\nHost:\ www

option httpchk OPTIONS * HTTP/1.1\r\nHost:\ www.magedu.com #server可以使用check检查,检查什么?怎么检查?可以发个ping命令,能够响应,也是正常的,但是跟web服务没有关系,,,,,,,,,,,,检查web服务正常有什么方法?我请求一个页面,这个页面能响应,而且值我也能得到,比如测试页,ok字符串,检查,能grep到ok,我们就认为是正常的,,,,,,,,,,,,所以option httpchk 就是明确定义httpd check的时候的检查方法,基于哪种方式检查,比如option httpchk <uri>,,,,,,,,,获取某一个uri,能获取到,就说明正常,,,,,,,,,,option httpchk <method> <uri>基于某种方法来获取uri,能获取到,说明也是正常,,,,,,,,option httpchk <method> <uri> <version>基于某种方法某种协议版本来获取uri,能获取到,说明也是正常,,,,,,,,,,,,, OPTIONS * 这是什么?表示所有方法(get,put,post,delete吧),,,,,,,,,, HTTP/1.1是协议版本,,,,,,,,,\r\n是回车,,,,,,,,,Host:\ www明确说明我请求的主机是www,,,,,,,这里反斜线空白表示就是使用空白字符的,,,,,,,,,,可以使用fqdn,全称 www.magedu.com ,,,,,,,,,,,,,,,,,很显然,它能探测某一个虚拟主机的, 只要这个虚拟主机在线,我们就说,它是在线的,,,,,,,对每一个server都执行类似的检查,,,,,,,,,,,,,,,所以 option httpchk 明确定义我们检查的方法是什么?

server apache1 192.168.1.1:443 check port 80??????

backend https_relay

mode tcp

option httpchk OPTIONS * HTTP/1.1\r\nHost:\ www.magedu.com

server apache1 192.168.1.1:443 check port 80??????

使用案例:

server first 172.16.100.7:1080 cookie first check inter 1000 #这个服务器叫first,172.16.100.7:1080是套接字,cookie 表示基于cookie作检查,,,, cookie first 表示cookie中要有first这个字符串,这里first应该是域名,马哥又说用first其实也可以,只不过我们需要在向客户端发送cookie( set cookie)的时候, 以first作为它的cookie标识,,,,,,,回头我们再来负载均衡同一个用户请求的时候,,它能够检查cookie,将用户的请求仍然发到这个server来的???? check inter 1000 表示间隔检查1000毫秒,,,

server second 172.16.100.8:1080 cookie second check inter 1000 #这个服务器叫second,172.16.100.7:1080是套接字,

3.9 capture request header

capture request header <name> len <length>

捕获并记录指定的请求首部最近一次出现时的第一个值,仅能用于“frontend”和“listen”区段。捕获的首部值使用花括号{}括起来后添加进日志中。如果需要捕获多个首部值,它们将以指定的次序出现在日志文件中,并以竖线“|”作为分隔符。不存在的首部记录为空字符串,最常需要捕获的首部包括在虚拟主机环境中使用的“Host”、上传请求首部中的“Content-length”、快速区别真实用户和网络机器人的“User-agent”,以及代理环境中记录真实请求来源的“X-Forward-For”。

<name>:要捕获的首部的名称,此名称不区分字符大小写,但建议与它们出现在首部中的格式相同,比如大写首字母。需要注意的是,记录在日志中的是首部对应的值,而非首部名称。

<length>:指定记录首部值时所记录的精确长度,超出的部分将会被忽略。

可以捕获的请求首部的个数没有限制,但每个捕获最多只能记录64个字符。为了保证同一个frontend中日志格式的统一性,首部捕获仅能在frontend中定义????。

3.10 capture response header

capture response header <name> len <length>

捕获并记录响应首部,其格式和要点同请求首部。

3.11 stats enable

启用基于程序编译时默认设置的统计报告,不能用于“frontend”区段。只要没有另外的其它设定,它们就会使用如下的配置:

- stats uri : /haproxy?stats

- stats realm : "HAProxy Statistics"

- stats auth : no authentication

- stats scope : no restriction

尽管“stats enable”一条就能够启用统计报告,但还是建议设定其它所有的参数,以免其依赖于默认设定而带来非期后果。下面是一个配置案例。

backend public_www

server websrv1 172.16.100.11:80

stats enable

stats hide-version

stats scope . #这是什么范围,这里的点是当前所在的backend范围

stats uri /haproxyadmin?stats

stats realm Haproxy\ Statistics #弹出用户名密码框的提示语吧

stats auth statsadmin:password #stats auth可以多个用户名密码

stats auth statsmaster:password

3.12 stats hide-version

stats hide-version

启用统计报告并隐藏HAProxy版本报告,不能用于“frontend”区段。默认情况下,统计页面会显示一些有用信息,包括HAProxy的版本号,然而,向所有人公开HAProxy的精确版本号是非常有风险的,因为它能帮助恶意用户快速定位版本的缺陷和漏洞??假如不隐藏,在哪里显示呢?。尽管“stats hide-version”一条就能够启用统计报告??????,但还是建议设定其它所有的参数,以免其依赖于默认设定而带来非期后果。具体请参照“stats enable”一节的说明。

3.13 stats realm

stats realm <realm>

启用统计报告并高精认证领域,不能用于“frontend”区段。haproxy在读取realm时会将其视作一个单词,因此,中间的任何空白字符都必须使用反斜线进行转义。此参数仅在与“stats auth”配置使用时有意义。

<realm>:实现HTTP基本认证时显示在浏览器中的领域名称,用于提示用户输入一个用户名和密码。

尽管“stats realm”一条就能够启用统计报告????,但还是建议设定其它所有的参数,以免其依赖于默认设定而带来非期后果。具体请参照“stats enable”一节的说明。

3.14 stats scope

stats scope { <name> | "." }

启用统计报告并限定报告的区段,不能用于“frontend”区段。当指定此语句时,统计报告将仅显示其列举出区段的报告信息,所有其它区段的信息将被隐藏。如果需要显示多个区段的统计报告,此语句可以定义多次。需要注意的是,区段名称检测仅仅是以字符串比较的方式进行,它不会真检测指定的区段是否真正存在??????。

<name>:可以是一个“listen”、“frontend”或“backend”区段的名称,而“.”则表示stats scope语句所定义的当前区段。

尽管“stats scope”一条就能够启用统计报告?????,但还是建议设定其它所有的参数,以免其依赖于默认设定而带来非期后果。下面是一个配置案例。

backend private_monitoring

stats enable

stats uri /haproxyadmin?stats

stats refresh 10s

3.15 stats auth

stats auth <user>:<passwd>

启用带认证的统计报告功能并授权一个用户帐号,其不能用于“frontend”区段。

<user>:授权进行访问的用户名;

<passwd>:此用户的访问密码,明文格式;

此语句将基于默认设定启用统计报告功能,并仅允许其定义的用户访问,其也可以定义多次以授权多个用户帐号。可以结合“stats realm”参数在提示用户认证时给出一个领域说明信息。在使用非法用户访问统计功能时,其将会响应一个“401 Forbidden”页面。其认证方式为HTTP Basic认证,密码传输会以明文方式进行,因此,配置文件中也使用明文方式存储以说明其非保密信息故此不能相同于其它关键性帐号的密码。

尽管“stats auth”一条就能够启用统计报告?????,但还是建议设定其它所有的参数,以免其依赖于默认设定而带来非期后果。

3.16 stats admin

stats admin { if | unless } <cond>

在指定的条件满足时启用统计报告页面的管理级别功能,它允许通过web接口启用或禁用服务器,不过,基于安全的角度考虑,统计报告页面应该尽可能为只读的????可写在哪里设置,只读在哪里设置????。此外,如果启用了HAProxy的多进程模式,启用此管理级别将有可能导致异常行为。

目前来说,POST请求方法被限制于仅能使用缓冲区减去保留部分之外的空间,因此,服务器列表不能过长,否则,此请求将无法正常工作????????。因此,建议一次仅调整少数几个服务器????????。下面是两个案例,第一个限制了仅能在本机打开报告页面时启用管理级别功能,第二个定义了仅允许通过认证的用户使用管理级别功能。

backend stats_localhost

stats enable

stats admin if LOCALHOST

backend stats_auth

stats enable

stats auth haproxyadmin:password

stats admin if TRUE

3.17 option httplog

option httplog [ clf ]

启用记录HTTP请求、会话状态和计时器的功能。

clf:使用CLF格式来代替HAProxy默认的HTTP格式,通常在使用仅支持CLF格式的特定日志分析器时才需要使用此格式。

默认情况下,日志输入格式非常简陋,因为其仅包括源地址、目标地址和实例名称,而“option httplog”参数将会使得日志格式变得丰富许多,其通常包括但不限于HTTP请求、连接计时器、会话状态、连接数、捕获的首部及cookie、“frontend”、“backend”及服务器名称,当然也包括源地址和端口号等。

3.18 option logasap #请求一到达时,提前记录,,而不是等到全部传输完成时才记录

no option logasap

option logasap

no option logasap

启用或禁用提前将HTTP请求记入日志,不能用于“backend”区段。

默认情况下,HTTP请求是在请求结束时进行记录以便能将其整体传输时长和字节数记入日志,由此,传较大的对象时,其记入日志的时长可能会略有延迟。“option logasap”参数能够在服务器发送complete首部时即时记录日志?????,只不过,此时将不记录整体传输时长和字节数。此情形下,捕获“Content-Length”响应首部来记录传输的字节数是一个较好选择??????。下面是一个例子。

listen http_proxy 0.0.0.0:80 #????

mode http

option httplog

option logasap

log 172.16.100.9 local2

3.19 option forwardfor

option forwardfor [ except <network> ] [ header <name> ] [ if-none ]

允许在发往服务器的请求首部中插入“X-Forwarded-For”首部。

<network>:可选参数,当指定时,源地址为匹配至此网络中的请求都禁用此功能。

<name>:可选参数,可使用一个自定义的首部,如“X-Client”来替代“X-Forwarded-For”。有些独特的web服务器的确需要用于一个独特的首部。

if-none:仅在此首部不存在时才将其添加至请求报文中??????哪个首部不存在?????。

HAProxy工作于反向代理模式,其发往服务器的请求中的客户端IP均为HAProxy主机的地址而非真正客户端的地址,这会使得服务器端的日志信息记录不了真正的请求来源,“X-Forwarded-For”首部则可用于解决此问题。HAProxy可以向每个发往服务器的请求上添加此首部,并以客户端IP为其value。

需要注意的是,HAProxy工作于隧道模式,其仅检查每一个连接的第一个请求,因此,仅第一个请求报文被附加此首部。如果想为每一个请求都附加此首部,请确保同时使用了“option httpclose”、“option forceclose”和“option http-server-close”几个option??????。

下面是一个例子。

frontend www

mode http

option forwardfor except 127.0.0.1

3.20 errorfile

errorfile <code> <file>

在用户请求不存在的页面时,返回一个页面文件给客户端而非由haproxy生成的错误代码;可用于所有段中。

<code>:指定对HTTP的哪些状态码返回指定的页面;这里可用的状态码有200、400、403、408、500、502、503和504;

<file>:指定用于响应的页面文件;

例如:

errorfile 400 /etc/haproxy/errorpages/400badreq.http

errorfile 403 /etc/haproxy/errorpages/403forbid.http

errorfile 503 /etc/haproxy/errorpages/503sorry.http

3.21 errorloc 和 errorloc302

errorloc <code> <url>

errorloc302 <code> <url>

请求错误时,返回一个HTTP重定向至某URL的信息;可用于所有配置段中。

<code>:指定对HTTP的哪些状态码返回指定的页面;这里可用的状态码有200、400、403、408、500、502、503和504;

<url>:Location首部中指定的页面位置的具体路径,可以是在当前服务器上的页面的相对路径,也可以使用绝对路径;需要注意的是,如果URI自身错误时产生某特定状态码信息的话,有可能会导致循环定向;

需要留意的是,这两个关键字都会返回302状态码,这将使得客户端使用同样的HTTP方法获取指定的URL????(原来是GET,还是用GET获取指定的URL,,,,,原来是PUT,还是用PUT获取指定的URL),对于非GET法的场景(如POST)来说会产生问题,因为返回客户的URL是不允许使用GET以外的其它方法的。如果的确有这种问题,可以使用errorloc303来返回303状态码给客户端。

3.22 errorloc303

errorloc303 <code> <url>

请求错误时,返回一个HTTP重定向至某URL的信息给客户端;可用于所有配置段中。

<code>:指定对HTTP的哪些状态码返回指定的页面;这里可用的状态码有400、403、408、500、502、503和504;

<url>:Location首部中指定的页面位置的具体路径,可以是在当前服务器上的页面的相对路径,也可以使用绝对路径;需要注意的是,如果URI自身错误时产生某特定状态码信息的话,有可能会导致循环定向;

例如:

backend webserver

server 172.16.100.6 172.16.100.6:80 check maxconn 3000 cookie srv01

server 172.16.100.7 172.16.100.7:80 check maxconn 3000 cookie srv02

errorloc 403 /etc/haproxy/errorpages/sorry.htm

errorloc 503 /etc/haproxy/errorpages/sorry.htm

一个配置示例:

#---------------------------------------------------------------------

# Global settings

#---------------------------------------------------------------------

global

# to have these messages end up in /var/log/haproxy.log you will

# need to:

#

# 1) configure syslog to accept network log events. This is done

# by adding the '-r' option to the SYSLOGD_OPTIONS in

# /etc/sysconfig/syslog

#

# 2) configure local2 events to go to the /var/log/haproxy.log

# file. A line like the following can be added to

# /etc/sysconfig/syslog

#

# local2.* /var/log/haproxy.log

#

log 127.0.0.1 local2

chroot /var/lib/haproxy

pidfile /var/run/haproxy.pid

maxconn 4000

user haproxy

group haproxy

daemon

defaults

mode http

log global

option httplog

option dontlognull

option http-server-close

option forwardfor except 127.0.0.0/8

option redispatch

retries 3

timeout http-request 10s

timeout queue 1m #队列 排队超时

timeout connect 10s

timeout client 1m

timeout server 1m

timeout http-keep-alive 10s

timeout check 10s

maxconn 30000

listen stats

mode http

bind 0.0.0.0:1080

stats enable

stats hide-version

stats uri /haproxyadmin?stats

stats realm Haproxy\ Statistics

stats auth admin:admin

stats admin if TRUE #假如上一行验证为真的话,才能进入管理界面 /haproxyadmin?stats

frontend http-in

bind *:80

mode http

log global

option httpclose

option logasap

option dontlognull

capture request header Host len 20

capture request header Referer len 60 #Referer 表示上一个页面,来自,引用的意思吧

default_backend servers

frontend healthcheck

bind :1099

mode http

option httpclose

option forwardfor

default_backend servers

backend servers

balance roundrobin

server websrv1 192.168.10.11:80 check maxconn 2000

server websrv2 192.168.10.12:80 check maxconn 2000

负载均衡MySQL服务的配置示例

#---------------------------------------------------------------------

# Global settings

#---------------------------------------------------------------------

global

# to have these messages end up in /var/log/haproxy.log you will

# need to:

#

# 1) configure syslog to accept network log events. This is done

# by adding the '-r' option to the SYSLOGD_OPTIONS in

# /etc/sysconfig/syslog

#

# 2) configure local2 events to go to the /var/log/haproxy.log

# file. A line like the following can be added to

# /etc/sysconfig/syslog

#

# local2.* /var/log/haproxy.log

#

log 127.0.0.1 local2

chroot /var/lib/haproxy

pidfile /var/run/haproxy.pid

maxconn 4000

user haproxy

group haproxy

daemon

defaults

mode tcp

log global

option httplog

option dontlognull #不记录空值

retries 3 #重试3次???

timeout http-request 10s

timeout queue 1m

timeout connect 10s

timeout client 1m

timeout server 1m

timeout http-keep-alive 10s #http?????保持活着超时

timeout check 10s

maxconn 600

listen stats #stats这里既有状态,又有统计的意思

mode http

bind 0.0.0.0:1080

stats enable

stats hide-version

stats uri /haproxyadmin?stats

stats realm Haproxy\ Statistics #密码框提示信息

stats auth admin:admin

stats admin if TRUE

frontend mysql

bind *:3306

mode tcp

log global

default_backend mysqlservers

backend mysqlservers

balance leastconn #最少连接

server dbsrv1 192.168.10.11:3306 check port 3306 intval 2 rise 1 fall 2 maxconn 300

server dbsrv2 192.168.10.12:3306 check port 3306 intval 2 rise 1 fall 2 maxconn 300

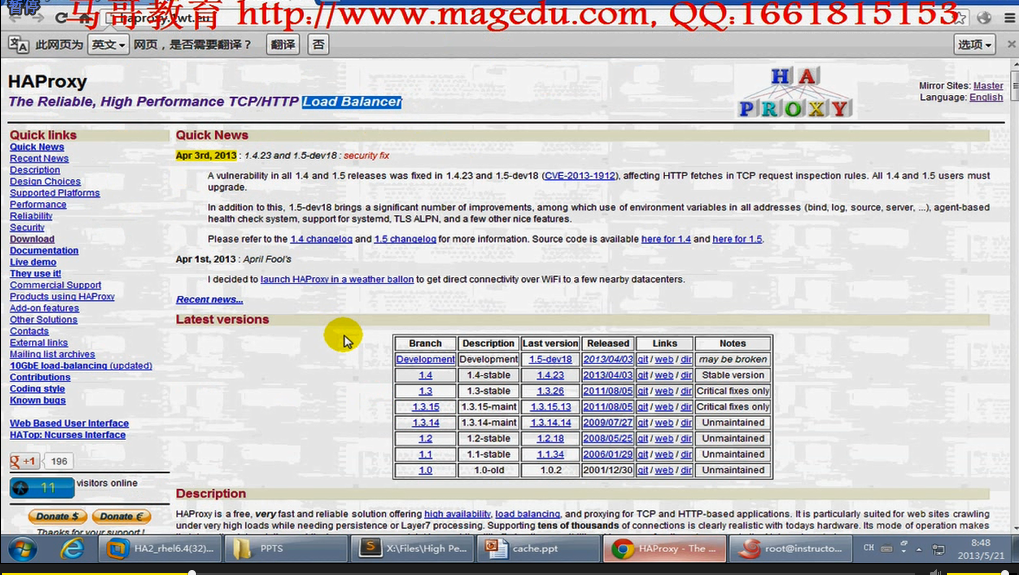

如下图图一当时,马哥说haproxy两个主流版本 1.4与.13其实功能差不多

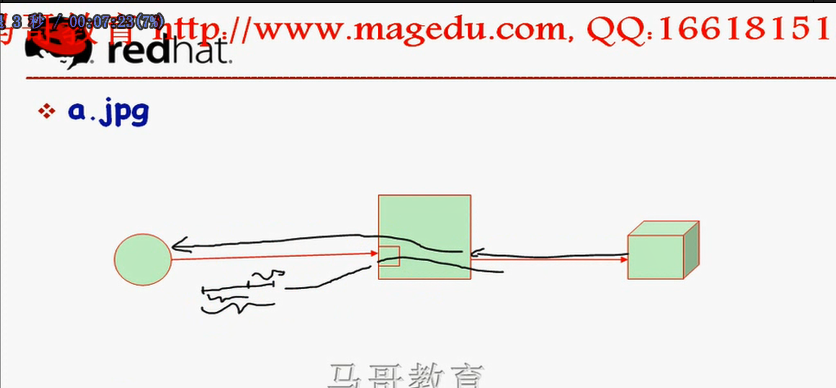

1.4 提供更好的弹性 支持客户端保持连接 支持tcp加速 支持响应报文缓冲(异步模式)(nginx也支持) 支持RDP???协议 支持源地址的粘性(相当于ip_hash,将来自于同一个客户端的请求始终定向到同一个real server) haproxy向后转发时是主要是基于URI转发(同一个URI,都定位到同一个后台,而不管客户端是谁) haproxy的这种调度均衡算法尤其适用于代理用户的请求至后端缓存服务器的,如下图图二,我们实现反向代理的时候,有的时候,不会让用户的请求直接送达到后端服务器上去,我们还期望为后端服务器生成的动静态结果给它缓存下来,如varish,而haproxy在实现用户请求调度的时候,可以根据用户请求的url来调度,意味着无论是来自哪个用户的请求,只要请求的是同一个url,都可以给你始终调度到同一个后端的缓存服务器上去,,,,,,缓存是根据url来建立的,基于url来调度,会大大提高缓存的命中率的,,,,,,,,, 所以尤其适用于为httpd服务反向代理至缓存服务器的时候使用,这也是很多站点之所以使用haproxy的重要原因,,,,,,,,,如果使用lua脚本来实现开发一些额外功能的话,事实上支持lua脚本的nginx也完全可以达到这个目的,只是nginx自身不能完成这个目的,,,,,,,,,支持非常友好的状态接口,输出各种状态信息,,,更详细的健康状况检查功能,,,,实现基于流量实现健康状况检查(只要要流量有认为是正常的,没必要发送额外请求到后端服务器检查,因为发额外请求会挤占有限带宽的),,,,支持http认证?????,,,,,支持通过命令行进行服务器端管理????,,,,,,,,支持 ACL 的持久连接(可以定义访问控制列表,明确将有些特性的用户归为一类??????,向后代理时怎么代理?????,而且在哪些时段内能访问???????等等),,,,,,,支持日志分析器,

1.3 支持内容交换及超高负载???? 支持内容交换 ACL 透明代理????? 内容探测?????? 负载均衡算法

图一,

图二,

我们的syslog定义日志的时候主要分为

facility.priority 哪一个系统(设施)产生哪一个级别的日志