You are here

网站robots.txt文件如何生成

百度站长工具生成:

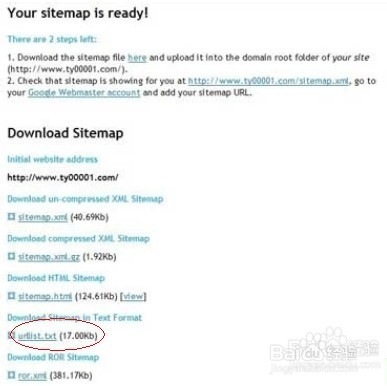

登陆百度站长平台(没账号的就要注册哦,这里就不介绍了),添加网站,如果您是第一次进入,就要添加网站,比如第二张图(写域名)

然后会有一个验证文件要下载,您占那个下载验证文件就可以下载了.下载之后把文件放到网站的根目录下.

当前面步骤操作完成后,回到站长平台点验证,成功后,双击网址

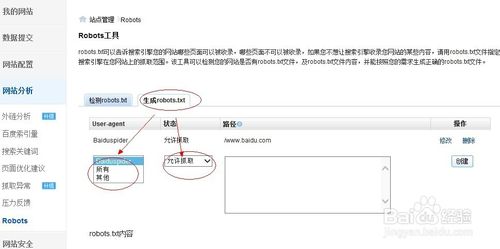

选择左手边的网站分析下的Robots

选择"生成robots.txt"处,然后User-agent按自己意愿选择,状态也是,如果您是允许就选择允许,如果是不允许就选择不允许,

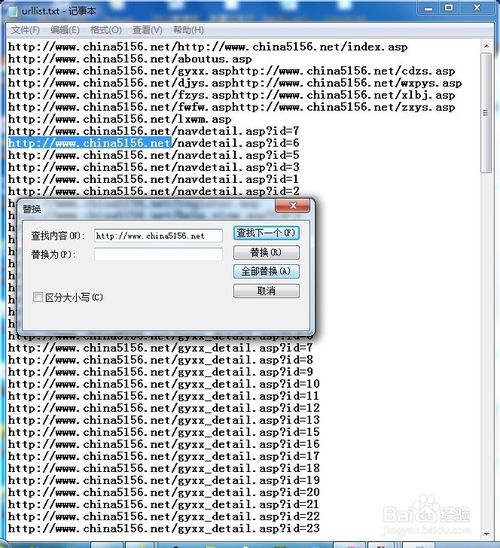

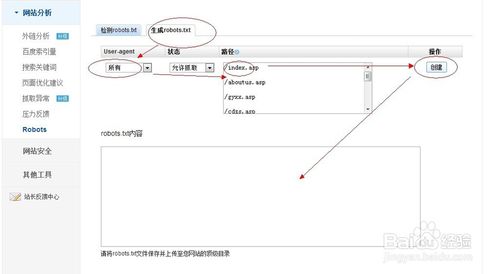

在路径框里复制刚才的第一步处理的urllist.txt文档的内容.粘贴到路径框里,格式都是/www.aaa.com类型的.后缀不强烈要求的.再点"创建",就会在上面记录一条信息,可以把允许与不允许同事记在同一个文件里,

这时可以看到下方的"robots.txt内容"就会出现相关内容.如果确认自己所有页面添加完成,就点"下载",然后再把该文件上传的根目录下就可以了.

robots.txt文件可以用手写的,但是有些网页太多了,手写麻烦而已,这可以看各人意愿啦.

小编就介绍到这里.希望你能成功.

END

注意事项

这是我看到很多地方都有说关于百度网页收录得出的结论,sitemap.只对其它搜索引擎有用,对百度就不太行,但小编也不能说绝对罗,只能说多做一个其它的,反正会更好,感谢您关注小编,如果觉得可以,请在上方点赞,同时想了解其它的网络可关注小编.

来自 https://jingyan.baidu.com/article/6c67b1d6da3ae02787bb1eed.html